RETOGAR: Retorno al hogar. Sistema de mejora de la autonomía de personas con daño cerebral adquirido y dependientes en su integración en la sociedad

Este proyecto ha sido financiado por el Ministerio de Economía y Competitividad del Gobierno de España dentro del Programa Estatal de I+D+i Orientada a los Retos de la Sociedad y confinanciado con fondos Feder europeos. La referencia del proyecto es TIN2016-76515-R y el título completo: RETOGAR: RETORNO AL HOGAR: SISTEMA DE MEJORA DE LA AUTONOMÍA DE PERSONAS CON DAÑO CEREBRAL ADQUIRIDO Y DEPENDIENTES EN SU INTEGRACIÓN EN LA SOCIEDAD

La atención de personas dependientes, ya sea por enfermedad, accidente, discapacidad, o envejecimiento, es una de las líneas prioritarias de investigación en los países desarrollados en la actualidad. Esta atención, además de servir de ayuda y compañía, se está planteando que sea incluso terapeútica. Por otra parte, se pretende que dicha atención sea en el hogar de la persona, con el objetivo de minimizar el coste de las terapias. La rehabilitación de los pacientes será completa cuando se consiga su integración en la sociedad, bien en el entorno familiar o en un entorno de trabajo y socialización.

Para dar solución a este desafío, el principal objetivo científico que persigue este proyecto es fomentar la salud y el bienestar de la sociedad a partir del diseño, desarrollo y evaluación de un asistente para personas con daño cerebral adquirido o dependientes que les ayude ante los retos que plantea su enfermedad en su integración social completa. Este asistente tiene una vertiente en el domicilio del paciente basada en el diseño y uso de un ambiente inteligente de monitorización y aprendizaje activo, y de un robot social autónomo de asistencia y estimulación interactiva en el hogar. Por otro lado, se contempla asistir a los pacientes también en entornos exteriores, ante desorientaciones o situaciones complejas. Esto implica la integración de tecnologías ya existentes, así como aportar nuevas soluciones a una diversidad de retos tecnológicos que este tipo de sistemas lleva emparejados. Además, se plantea una evaluación experimental llevada a cabo por profesionales clínicos que valorarán la eficacia del sistema en la mejora de la calidad de vida de las personas dependientes. Se evaluará tanto la autonomía como el estado cognitivo–afectivo positivo del paciente.

Para conseguir el objetivo general propuesto es necesario abordar ciertos retos científicos-tecnológicos que se desglosan en los siguientes objetivos específicos: i) desarrollar un sistema inteligente de monitorización del entorno robusto, que permita realizar la localización y seguimiento, de manera precisa, de los individuos presentes en un escenario; ii) Desarrollar un sistema robusto de localización y navegación, y de reconocimiento y manipulación de objetos 3D de tamaño reducido a bordo del robot. iii) Diseñar un asistente personalizado para ayudar al paciente ante situaciones de fallos de memoria, falta de orientación, dificultades motoras, visibilidad reducida por hemiplejias y otras situaciones. Dicho sistema será entrenado con conductas y escenarios habituales en interiores y exteriores. iv) Dotar al asistente de capacidades de interacción natural usando novedosas técnicas de procesamiento de lenguaje natural combinados con atención visual y aprendizaje profundo. v) realizar un diseño del escenario de atención y rehabilitación, e identificar métricas, pilotaje y evaluación final del sistema desarrollado con escenarios y pacientes reales; y por último vi) difundir y divulgar los resultados obtenidos a la comunidad científica y a empresas y asociaciones relacionadas con el sector.

Los resultados esperados son de diversa índole. A nivel científico-técnico se espera conseguir avances significativos en las distintas tecnologías a desarrollar.En cuanto al impacto social se pretende mejorar la calidad de vida de los pacientes. En cuanto al impacto económico,se espera poder obtener un sistema funcional,y su posible comercialización aumentando la transferencia de tecnología hacia la sociedad

Objetivos

Objetivo 1. Diseñar un sistema de ambiente inteligente de monitorización del entorno, basado en sensores visuales 3D de bajo coste, que permita realizar la localización y seguimiento de personas de manera robusta y precisa en su hogar.

Objetivo 2. Desarrollar un sistema robusto de localización y navegación, y de reconocimiento y manipulación de objetos 3D de tamaño reducido a bordo del robot mediante técnicas de aprendizaje profundo.

Objetivo 3: Diseñar un asistente personalizado en el hogar basado en técnicas de aprendizaje profundo especializadas en secuencias temporales para ayudar al paciente ante situaciones de fallos cognitivos.

Objetivo 4: Desarrollar un sistema asistente de ayuda al paciente en exteriores basado en sensores de visión vestibles e información de localización. El paciente debe ser capaz de poder desplazarse en exteriores con una cierta ayuda. Las secuelas derivadas de esta enfermedad producen desorientación y pérdida temporal de memoria. Pretendemos añadir un sistema que en exteriores también aumente la autonomía del paciente.

Objetivo 5: Realizar la integración de los diferentes sistemas y un diseño de escenarios de atención e identificar métricas, pilotaje y evaluación final del sistema desarrollado con escenarios interiores y exteriores, y pacientes reales Todo el sistema debe ser probado con pacientes reales. En este objetivo se realizarán tareas para llevar a cabo estas pruebas. Esta tarea la realizarán los especialistas de la fundación Casaverde. Estos especialistas nos irán dando realimentación en todo momento para poder desarrollar un sistema que se ajuste mejor a sus necesidades.

Objetivo 6: Realizar una coordinación de los objetivos planteados y la difusión los resultados del proyecto

Evolución del cumplimiento de los objetivos

Para cada objetivo indicamos los resultados obtenidos y su grado de consecución.

Actividad 1. Diseñar un sistema de ambiente inteligente de monitorización del entorno, basado en sensores visuales 3D de bajo coste, que permita realizar la localización y seguimiento de manera precisa en su hogar. Este objetivo se ha cumplido al 60%, tanto en los hitos a conseguir como en los entregables a realizar. Todavía queda, tal como refleja la planificación, terminar el seguimiento 3D de personas. También queda por realizar el O1T3, el cual analizaría el comportamiento de la persona. Por último, quedarían las pruebas finales de despliegue del sistema.

En esta actividad hemos desarrollado e implantado el sistema en nuestro laboratorio. El sistema estará protegido por patente, por lo que no se han realizado publicaciones. En la actualidad, estamos mejorando los métodos de aprendizaje profundo usados para obtener mejores resultados.

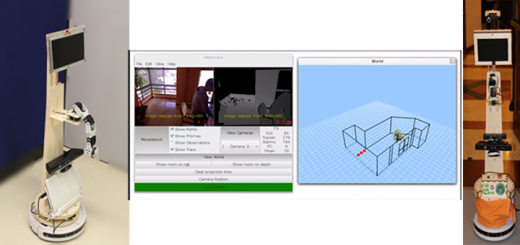

Actividad 2. Desarrollar un sistema robusto de localización y navegación, y de reconocimiento y manipulación de objetos 3D de tamaño reducido a bordo del robot mediante técnicas de aprendizaje profundo. También se ha cumplido un 60% de la consecución del objetivo. Estamos finalizando el sistema de reconocimiento de objetos 3D, así como la manipulación de objetos. Se ha realizado un análisis de la seguridad en sistemas robóticos distribuidos [1]. También hemos avanzado en localización semántica en interiores, para ayudar al robot a saber en qué tipo de sala se encuentra[1][1][1][1]. Se ha realizado un método de compresión y registro de datos 3D[1], varios para reconocimiento de objetos en 3D[1][1] [1] y un estudio del efecto del ruido con oclusión para reconocimiento de objetos 3D[1]. En[1] se realiza un mapeado 3D para navegación a largo plazo. Por último, se ha empezado a trabajar en manipulación de objetos

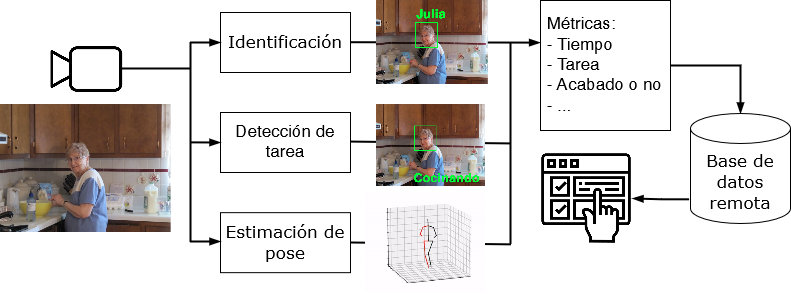

Actividad 3. Diseñar un asistente personalizado en el hogar basado en técnicas de aprendizaje profundo especializadas en secuencias temporales para ayudar al paciente ante situaciones de fallos cognitivos. Se ha cumplido el 60% del objetivo. Ya hemos realizado el reconocimiento de actividades cotidianas del paciente, aunque necesitamos más tiempo para terminarlo. De la misma manera, estamos desarrollando una agenda de actividades para el paciente. Junto con un grupo especializado en recomendadores, hemos realizado un sistema asistente para ejercicios con personas de la tercera edad[2][j1].[2][c12] está relacionado con el anterior, donde se exploran los aspectos prácticos del despliegue de este tipo de sistemas. Por otro lado, hemos avanzado en el procesamiento de imágenes con Deep learning, revisando el estado del arte en segmentación para imagen y vídeo[2] [j2]. Hemos realizado un asistente mediante realidad aumentada para guiado en un entorno conocido [2] [j6] y un reconocedor de gestos[2][j12][2][c4] y actividades [2] [j13] para personas con discapacidad. También hemos revisado el estado del arte en aprendizaje automático para la interacción humano-robot[2][j14]. En[2][c11] hemos empezado a desarrollar un sistema de reconocimiento de la posición de la mano, el cual servirá para reconocer gestos más complejos. En[2][c13] se desarrolla un método de identificación de personas a partir de un láser y las piernas.

Actividad 4. Desarrollar un sistema de ayuda al paciente en exteriores basado en sensores de visión vestibles e información de localización. Lo tenemos terminado al 75%. Quedan por desarrollar las interfaces para la comunicación con el paciente, así como de la aplicación para desplegarla en el dispositivo de ayuda. Se ha realizado un método para la detección del movimiento de un peatón[2][j8][2][c5]. También se ha realizado un dataset con objetos presentes en escenarios de tráfico[2][c2]. Se han comprado cámaras vestibles para su uso en esta actividad.

Actividad 5. Realizar la integración de los diferentes sistemas y un diseño de escenarios de atención e identificar métricas, pilotaje y evaluación final del sistema desarrollado con escenarios interiores y exteriores, y pacientes reales. Este objetivo todavía no se ha empezado a desarrollar, puesto que su comienzo se prevé para el mes 24.

Actividad 6. Realizar una coordinación de los objetivos planteados y la difusión de los resultados del proyecto. Nos encontramos al 50%. Este objetivo se realiza durante todo el proyecto (coordinación, publicaciones, difusión, etc.). Se han realizado todas las actividades de coordinación (reuniones periódicas, ya sea presenciales o por videoconferencia). La página web del proyecto está visible en http://www.rovit.ua.es/retogar-retorno-al-hogar-sistema-de-mejora-de-la-autonomia-de-personas-con-dano-cerebral-adquirido-y-dependientes-en-su-integracion-en-la-sociedad

Disponemos de un carpeta en GDrive para la gestión interna del proyecto, donde disponemos de las actas de las reuniones realizadas así como los vídeos y la documentación asociada a las hitos. El proyecto se ha difundido en prensa nacional, tal como se puede ver en la web del proyecto, apartado de noticias en prensa

Personal

- Miguel Cazorla (Investigador principal)

- José García Rodríguez (Investigador principal)

- Diego Viejo

- Javier Montoyo

- Sergio Orts Escolano

- José María Cañas (Universidad Rey Juan Carlos)

- Francisco Martín (Universidad Rey Juan Carlos)

- Eugenio Aguirre (Universidad de Granada)

- Miguel García Silvente (Universidad de Granada)

Resultados del proyecto

j journal

c conference

t PhD thesis

[J1] Angelo Costa, Ester Martinez-Martin, Miguel Cazorla and Vicente Julian PHAROS—PHysical Assistant RObot System, Sensors, 18(8), 2018

[j2] Francisco Martín, Enrique Soriano, José M. Cañas, Quantitative analysis of security in distributed robotic frameworks, Robotics and Autonomous Systems, Volume 100, 2018, Pages 95-107

[j3] A. Garcia-Garcia, S. Orts-Escolano, S. Oprea, V. Villena-Martinez, P. Martinez-Gonzalez, J. Garcia-Rodriguez .A Survey on Deep Learning Techniques for Image and Video Semantic Segmentation. Applied Soft Computing, vol. 70. 2018.

[j4] J. C. Rangel, M. Cazorla, I. García-Varea, C. Romero-González, J. Martínez-Gómez, “Automatic Semantic Maps Generation from Lexical Annotations” Autonomous Robots, Aceptado, 2018.

[j5] J. Navarrete-Sanchez, D. Viejo and M. Cazorla, “Compression and Registration of 3D Point Clouds Using GMMs” Pattern Recognition Letters, vol 110, pp 8-15, 2018.

[j6] Edmanuel Cruz, Sergio Orts-Escolano, Francisco Gómez-Donoso, Carlos Rizo, Jose Carlos Rangel, Higinio Mora, Miguel Cazorla. An augmented reality application for improving shopping experience in large retail stores. Virtual Reality. Aceptado para publicación 2018.

[j7] J.C. Rangel Ortiz, J. Martinez Gomez, C. Romero Gonzalez, I. Garcia Varea and M. Cazorla, “Semi-supervised 3D Object Recognition through CNN Labeling” Applied Soft Computing, vol 65, 2018.

[j8] A. Dominguez-Sanchez, M. Cazorla, and S. Orts-Escolano, “Pedestrian movement direction recognition using convolutional neural networks,” IEEE transactions on Intelligent transportation Systems, vol. 18, num. 12, pp. 3540-3528, 2017.

[j9] A. G. García, J. G. Rodríguez, S. Orts-Escolano, S. Oprea, F. G. Donoso, and M. Cazorla, “A ſtudy of the effect of noise and occlusion on the accuracy of convolutional neural networks applied to 3d object recognition,” Computer vision and ımage understanding, vol. 164, pp. 124-134, 2017.

[j11] F. Gomez-Donoso, S. Orts Escolano, M. Cazorla, A. Garcia-Garcia, J. Garcia-Rodriguez, J. A. Castro-Vargas, and S. Ovidiu-Oprea, “A robotic platform for customized and interactive rehabilitation of persons with disabilities,” Pattern recognition letters, vol. 99, pp. 105-113, 2017.

[j12] SO Oprea, A Garcia‐Garcia, S Orts‐Escolano, V Villena‐Martinez, JA Castro‐Vargas, “A long short-term memory based Schaeffer gesture recognition system”, Expert Systems, vol 35, issue 2, 2017

[j13] J. Abellan, A. García-Garcia, S-O Oprea, D. Ivorra, and J. Garcia-Rodriguez, “Classifying Behaviours in Videos with Recurrent Neural Networks”, International Journal of Computer Vision and Image Processing, 7(4) 1-15, 2017.

[j14] Mauricio Andres Zamora Hernandez, Eldon Caldwell Marin, Jose Garcia-Rodriguez, Jorge Azorin-Lopez, Miguel Cazorla, “Automatic Learning Improves Human-Robot Interaction in Productive Environments: A Review”, International Journal of Computer Vision and Image Processing, 7(3) 65-75, 2017.

[j15] F. Escalona, Á. Rodríguez, F. Gómez-Donoso, J. Martínez-Gómez, and M. Cazorla, “3d object detection with deep learning,” Journal of physical agents, vol. 8, iss. 1, 2017.

[j16] Zuria Bauer, Francisco Gomez-Donoso, Edmanuel Cruz, Sergio Orts-Escolano, and Miguel Cazorla, UASOL, a Large-scale High-resolution Outdoor Stereo Dataset. Scientific data, Vol 6, num 1, 2019

[j17] Francisco Gomez-Donoso, Sergio Orts-Escolano and Miguel Cazorla, Accurate and Efficient 3D Hand Pose Regression for Robot Hand Teleoperation using a Monocular RGB Camera. Expert Systems With Applications, Vol 136 ,pp 327-337, 2019

[j18] Pablo Martinez-Gonzalez, Sergiu Oprea, Alberto Garcia-Garcia, Alvaro Jover-Alvarez, Sergio Orts-Escolano, Jose Garcia-Rodriguez. UnrealROX: an extremely photorealistic virtual reality environment for robotics simulations and synthetic data generation. Virtual Reality, 2019. https://doi.org/10.1007/s10055-019-00399-5, 2019

[j19] Sergiu Oprea, Pablo Martínez González, Alberto García García, John Alejandro Castro Vargas, Sergio Orts Escolano and Jose García Rodríguez. A visually realistic grasping system for object manipulation and interaction in virtual reality environments. Computers & Graphics, 2019, https://doi.org/10.1016/j.cag.2019.07.003

[j20] Jose Garcia-Rodriguez, Anastasia Angelopoulou, David Tomas, and Andrew Lewis. Complex Methods Applied to Data Analysis, Processing, and Visualisation. Complexity, 2019, , https://doi.org/10.1155/2019/9316123

[j21] Ester Martínez-Marin and Miguel Cazorla, A Socially Assistive Robot for Elderly Exercise Promotion. IEEE Access, vol. 7. pp 75515-75529, 2019

[j22] Edmanuel Cruz, José Carlos Rangel, Francisco Gomez-Donoso and Miguel Cazorla, How to add new knowledge to already trained deep learning models applied to semantic localization. Applied Intelligence, https://doi.org/10.1007/s10489-019-01517-1 2019

[j23] Ester Martinez-Martin and Miguel Cazorla, Rehabilitation Technology: Assistance From Hospital to Home. Computational Intelligence and Neuroscience, vol 2019, 2019

[j24] Eugenio Aguirre and Miguel García-Silvente, “Using a deep learning model on images to obtain a 2D laser people detector for a mobile robot,” International Journal of Computational Intelligence Systems, vol 12, n 2, pp 476-484, 2019

[j25] Anastassia Angelopoulou, Jose Garcia-Rodriguez, Sergio Orts-Escolano, Epaminondas Kapetanios, Xing Liang, Bencie Wol, “Evaluation of Different Chrominance Models in the Detection and Reconstruction of Faces and Hands using the Growing Neural Gas Network.”, Pattern Analysis and Applications, https://doi.org/10.1007/s10044-019-00819-x, 2019

[j26] Bauer, A. Dominguez, E. Cruz, F. Gomez-Donoso, S. Orts-Escolano, and M. Cazorla, “Enhancing perception for the visually ımpaired with deep learning techniques and low-cost wearable sensors,” Pattern recognition letters, vol. Accepted, 2019

[j27] Francisco Gomez-Donoso, Felix Escalona, Francisco Rivas-Montero, José M. Cañas and Miguel Cazorla «Enhancing the Ambient Assisted Living Capabilities with a Mobile Robot».Computational Intelligence and Neuroscience. vol. 2019. 2019

[j28] Jose Garcia-Rodriguez; Francisco Gomez-Donoso; Alberto Garcia-Garcia; Miguel Cazorla; Sergio Orts-Escolano; Sergiu Oprea; Zuria Bauer; John Castro-Vargas; Pablo Martinez-Gonzalez; David Ivorra-Piqueres; Félix Escalona-Moncholí; Eugenio Aguirre; Miguel Garcia-Silviente; Marcelo Garcia-Perez; Jose M Cañas; Francisco Martin-Rico; Jonathan Gines; Francisco Rivas-Montero » COMBAHO: A Deep Learning System for Integrating Brain Injury Patients in Society». Pattern Recognition Letters. https://doi.org/10.1016/j.patrec.2019.02.013, 2019

[j29] Nadia Nasri, Sergio Orts-Escolano, Francisco Gomez-Donoso, Miguel Cazorla «INFERRING STATIC HAND POSES FROM A LOW-COST NON-INTRUSIVE sEMG SENSOR». Sensors 19(2): 371, 2019

[j30] Francisco Martín Rico, Vicente Matellán Olivera, Francisco J. Rodriguez Lera and Jonathan Ginés «Octree-based localization using RGB-D data for indoor robots». Engineering Applications of Artificial Intelligence. Volume 77, Pages 177-185, 2019

[j31] Francisco Gomez-Donoso, Sergio Orts-Escolano and Miguel Cazorla, “Large-scale Multiview 3D Hand Pose Dataset”, Image and Vision Computing. 2019 Vol 85, pp. 25-33

[j32] Jose Garcia-Rodriguez, Isabelle Guyon, Sergio Escalera, Alexandra Psarrou, Andrew Lewis, Juxi Leitner, “ Machine Learning Methods for Vision and Robotics”, Expert Systems,vol 35, issue 2, 2018

[j33] Francisco J. Rodriguez Lera, Francisco Martín Rico, and Vicente Matellán Olivera «Neural Networks for Recognizing Human Activities in Home-like Environments». Integrated Computer-Aided Engineering. vol. 26, no. 1, pp. 37-47, 2019

[j34] Francisco Javier Rodríguez Lera, Vicente Matellán Olivera, Miguel Ángel Conde, Francisco Martín. «HiMoP: A three-components architecture to create more human-acceptable social-assistive robots». Cognitive Processing. 19:2, 233-244, 2018

[j35] Álvarez-Aparicio, C. , Guerrero-Higueras, Á. M., Olivera, V., Rodríguez-Lera, F. J., Martín, F., & Matellán, V. “Benchmark Dataset for Evaluation of Range-Based People Tracker Classifiers in Mobile Robots” Frontiers in neurorobotics vol. 11 72. 15 Jan. 2018

[j36] Edmanuel Cruz, Felix Escalona, Zuria Bauer, Miguel Cazorla, Jose Garcia-Rodriguez, Ester Martinez-Martin, Jose Carlos Rangel and Francisco Gomez-Donoso, Geoffrey: An Automated Schedule System on a Social Robot for the Intellectually Challenged. Computational Intelligence and Neuroscience, vol 2018, 2018

[j37] Alejandro Dominguez-Sanchez, Miguel Cazorla and Sergio Orts-Escolano A New Dataset and Performance Evaluation of a Region-based CNN for Urban Object Detection, Electronics, 7(11), 301; doi: 10.3390/electronics7110301, 2018

[c1] Edmanuel Cruz, Jose Carlos Rangel, Francisco Gómez-Donoso, Jose Garcia-Rodriguez, Miguel Cazorla. Finding the place: how to train and use convolutional neural networks for a dynamically learning robot. IJCNN 2018. Oral

[c2] Alejandro Dominguez, Sergio Orts-Escolano, Miguel Cazorla. A New Dataset and Performance Evaluation of a Region-based CNN for Urban Object Detection. IJCNN 2018.Oral

[c3]F. Gomez-Donoso, A. Garcia-Garcia, S. Orts-Escolano, J. Garcia-Rodriguez, and M. Cazorla, “Lonchanet: a ſliced-based cnn architecture for real-time 3d object recognition,” in 2017 ınternational joint conference on neural networks (ıjcnn), 2017. Oral

[c4] S. Oprea, A. Garcia-Garcia, S. Orts-Escolano, J. Garcia-Rodriguez, and M. Cazorla, “A recurrent neural network based ſchaeffer gesture recognition ſystem,” in 2017 ınternational joint conference on neural networks (ıjcnn), 2017. Oral

[c5] Alex Dominguez-Sanchez, Sergio Orts-Escolano and Miguel Cazorla, “Pedestrian Direction Recognition using Convolutional Neural Networks,” in 14th International Work-Conference on Artificial Neural Networks (IWANN), 2017. Oral

[c6] Mauricio Zamora, Eldon Caldwell, Jose Garcia-Rodriguez, Jorge Azorin-Lopez and Miguel Cazorla, “Machine learning improves human-robot interaction in productive environments: A review,” in 14th International Work-Conference on Artificial Neural Networks (IWANN), 2017. Oral

[c7] Jaime Salvador, Zoila Ruiz, and Jose Garcia-Rodriguez, ”Big Data Infrastructure: A Survey. “in 14th International Work-Conference on Artificial Neural Networks (IWANN), 2017. Oral

[c8] Zoila Ruiz, Jaime Salvador and Jose Garcia-Rodriguez, ”A Survey of Machine Learning Methods for Big Data. “in 14th International Work-Conference on Artificial Neural Networks (IWANN), 2017. Oral

[c9] Edmanuel Cruz, Jose Carlos Rangel, Miguel Cazorla, Robot Semantic Localization Through CNN Descriptors. ROBOT 2017: Third Iberian Robotics Conference – Volume 1, Seville, Spain, November 22-24, 2017

[c10] Felix Escalona, Francisco Gomez-Donoso, Miguel Cazorla, Robot Semantic 3D Object Mapping Using a Labelling System. ROBOT 2017: Third Iberian Robotics Conference – Volume 1, Seville, Spain, November 22-24, 2017

[c11] Francisco Gomez-Donoso, Sergio Orts-Escolano, Miguel Cazorla, Robust Hand Pose Regression Using Convolutional Neural Networks. ROBOT 2017: Third Iberian Robotics Conference – Volume 1, Seville, Spain, November 22-24, 2017

[c12] Francisco Martín, Jonathan Gines, Practical Aspects of Deploying Robotherapy Systems. ROBOT 2017: Third Iberian Robotics Conference – Volume 1, Seville, Spain, November 22-24, 2017

[c13] Eugenio Aguirre, Miguel García-Silvente, Marcelo García-Pérez, Learning Leg Pattern Using Laser Range Finder in Mobile Robots. ROBOT 2017: Third Iberian Robotics Conference – Volume 1, Seville, Spain, November 22-24, 2017

[c14] Jonathan Ginés, Francisco Martín, Vicente Matellán, Francisco Rodríguez Lera, Jesús Balsa, 3D Mapping for a Reliable Long-Term Navigation. ROBOT 2017: Third Iberian Robotics Conference – Volume 1, Seville, Spain, November 22-24, 2017

[c15] Brayan Impata, Alberto Garcia, Sergio Orts, Pablo Gil, Jose Garcia. Tactile Graphs for Grasp Stability Prediction., In Proc. of the International Conference on Learning Representations, ICLR 2019 Workshop on Representation Learning on Graphs and Manifolds. New Orleans, (US), May, 2019

[c16] John Alejandro Castro Vargas, Alberto Garcia Garcia, Sergiu Oprea, Pablo Martinez Gonzalez and Jose Garcia Rodriguez, 3d hand joints position estimation with graph covolutional networks: a GraphHands baseline. in Proc. of the ROBOT’2019: Fourth Iberian Robotics Conference, Porto. Portugal, November 2019

[c17] Jose Miguel Torres-Camara, Felix Escalona, Francisco Gomez-Donoso and Miguel Cazorla, Map Slammer: Densifying Scattered KSLAM 3D Maps with Estimated Depth. in Proc. of the ROBOT’2019: Fourth Iberian Robotics Conference, Porto. Portugal, November 2019

[c18] David Azuar, Guillermo Gallud, Felix Escalona, Francisco Gomez-Donoso and Miguel Cazorla, A Story-telling Social Robot with Emotion Recognition Capabilities for the Intellectually Challenged. in Proc. of the ROBOT’2019: Fourth Iberian Robotics Conference, Porto. Portugal, November 2019

[c19] Nadia Nasri, Sergio Orts-Escolano, Francisco Gomez-Donoso and Miguel Cazorla, “USING INFERRED GESTURES FROM SEMG SIGNAL TO TELEOPERATE A DOMESTIC ROBOT FOR THE DISABLED,” in Proc. of the 15th International Work-Conference on Artificial Neural Networks (IWWAN), 2019

[c20] Francisco Martin-Rico, Francisco Gomez-Donoso, Felix Escalona, Miguel Cazorla and Jose Garcia-Rodriguez, “Artificial Semantic Memory with Autonomous Learning applied to Social Robots,” in 2019 International Work-Conference on the Interplay Between Natural and Artificial Computation (IWINAC), 2019

[c21] Alberto Garcia-Garcia, Brayan S. Zapata-Impata, Sergio Orts-Escolano, Pablo Gil and Jose Garcia-Rodriguez, “TactileGCN: A Graph Convolutional Network for Predicting Grasp Stability with Tactile Sensors,” in 2019 International joint conference on neural networks (ıjcnn), 2019

[c22] Francisco Martín, Jonathan Ginés, David Vargas, Francisco J. Rodríguez-Lera, Vicente Matellán. «Planning-centered Architecture for RoboCup SSPL @Home», WAF2018, published in Advances in Intelligent Systems and Computing series. November 2018.

[c23] Francisco Martín, Jonathan Ginés, David Vargas, Francisco J. Rodríguez-Lera, Vicente Matellán. «Planning Topological Navigation for complex Indoor Environments», 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS 2018). October 2018.

[c24] Alberto Garcia-Garcia, Pablo Martinez-Gonzalez, Sergiu Oprea, John Castro-Vargas, Sergio Orts-Escolano, Jose Garcia-Rodriguez. “The RobotriX: An Extremely Photorealistic and Very-Large-Scale Indoor Dataset of Sequences with Robot Trajectories and Interactions”, 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS 2018). October 2018.

[c25] Francisco J. Rodríguez-Lera, Vicente Matellán and Francisco Martín,. «Generating Symbolic Representation from Sensor Data: Inferring knowledge in Robotics Competitions», 18th International Conference on Autonomous Robot Systems and Competitions (ICARSC 2018). April 2018

[t1] Jose Carlos Rangel, Scene Understanding for Mobile Robots exploiting Deep Learning Techniques. PhD Thesis, 2017. Universidad de Alicante, Spain. Supervisors: Miguel Cazorla y Jesús Martínez. International Doctor Mention.

[t2] Julio Vega, Educational framework using robots with vision for constructivist teaching Robotics to pre-university students. PhD Thesis, 2018. Universidad de Alicante, Spain Directores: Miguel Cazorla y José María Cañas. International Doctor Mentionl.

[t3] Alejandro Domínguez Sánchez: Recognition of driving objects in real time with computer vision and deep neural networks. Supervisors: Miguel Cazorla and Sergio Orts. Date: December 2018.

[t4] Jaime Salvador Meneses: Optimización y Procesamiento Inteligente de Grandes Volúmenes de Datos Categóricos. Supervisor: José García Rodríguez.Date: Junio 2019

[t5] Zoila Ruíz Chávez: Técnicas de Aprendizaje Automático Aplicadas al Procesamiento de Información Demográfica. Supervisor: José García Rodríguez. Date: Junio 2019

[t6] Alberto García García, Deep Learning for 3D Perception: Computer Vision and Tactile Sensing, Supervisors: José García Rodríguez, Sergio Orts. Date: October 2019.

Noticias en prensa

http://m.eldiario.es/sociedad/retorno-hogar-personas-discapacidad-robot_0_638686247.html

http://eldia.es/sociedad/2017-05-01/9-robot-ayuda-personas-discapacidad-desenvolverse.htm

http://www.iberoamerica.net/espana/prensa-economica/eleconomista.es/20170430/noticia.html?id=j2ei0xO

http://www.diarioinformacion.com/universidad/2017/05/01/robot-asiste-vuelta-hogar/1889037.html

http://www.diarioinformacion.com/alicante/2017/11/18/inteligencia-artificial/1958993.html

Noticia sobre Pharos

https://www.diarioinformacion.com/alicante/2018/10/15/robot-vigila-salud-mayores/2074058.html

https://www.agenciasinc.es/Noticias/Pharos-un-robot-para-ayudar-a-los-mayores-a-hacer-ejercicio

http://uruguay.shafaqna.com/ES/AL/46682

http://laopiniondelagente-es.blogspot.com/2018/10/el-robot-que-ayuda-los-mayores.html

http://cadenaser.com/emisora/2018/10/14/radio_valencia/1539504818_963476.html

https://www.levante-emv.com/comunitat-valenciana/2018/10/15/robot-ayuda-mayores/1780873.html

https://www.nobbot.com/futuro/entrenador-personal-pharos-pepper/

TVE informativo regional: https://twitter.com/RTVEValencia/status/1052639080780050436

https://ominho.pt/projeto-da-uminho-cria-robot-personal-trainer-para-idosos/

https://semanariov.pt/2018/10/14/universidade-do-minho-desenvolve-robot-personal-trainer-de-idosos/

https://www.tveuropa.pt/noticias/robo-personal-trainer-de-idosos-esta-a-nascer-no-minho/

https://tvi24.iol.pt/tecnologia/19-10-2018/criado-robot-personal-trainer-para-idosos

http://bomdia.eu/robot-personal-trainer-criado-por-portugueses-e-espanhois/

http://ruvid.org/wordpress/?p=42988

https://www.agenciasinc.es/Noticias/Pharos-un-robot-para-ayudar-a-los-mayores-a-hacer-ejercicio

https://medicalxpress.com/news/2018-10-robot-elderly-underlying-health-problems.html

https://vaaju.com/aus/new-robot-helps-older-exercise-and-detects-underlying-health-problems/

https://tech2.org/aus/new-robot-helps-older-people-exercise-and-detects-underlying-health-problems/

[Bibtex]

[Bibtex]

@article{Azorin2016b,

abstract = {Human behaviour recognition has been, and still remains, a challenging problem that involves different areas of computational intelligence. The automated understanding of people activities from video sequences is an open research topic in which the computer vision and pattern recognition areas have made big efforts. In this paper, the problem is studied from a prediction point of view. We propose a novel method able to early detect behaviour using a small portion of the input, in addition to the capabilities of it to predict behaviour from new inputs. specifically, we propose a predictive method based on a simple representation of trajectories of a person in the scene which allows a high level understanding of the global human behaviour. The representation of the trajectory is used as a descriptor of the activity of the individual. The descriptors are used as a cue of a classification stage for pattern recognition purposes. Classifiers are trained using the trajectory representation of the complete sequence. However, partial sequences are processed to evaluate the early prediction capabilities having a specific observation time of the scene. The experiments have been carried out using the three different dataset of the CAVIAR database taken into account the behaviour of an individual. Additionally, different classic classifiers have been used for experimentation in order to evaluate the robustness of the proposal. Results confirm the high accuracy of the proposal on the early recognition of people behaviours.},

author = {{Jorge Azorin-Lopez, Marcelo saval-Calvo, Andres Fuster-Guillo}, Jose Garcia-Rodriguez},

journal = {Neural Processing Letters},

number = {2},

pages = {363--387},

title = {{A novel prediction method for early recognition of global human behaviour in image sequences}},

volume = {43},

year = {2015}

}