Fusión sensorial y SLAM activo cooperativo

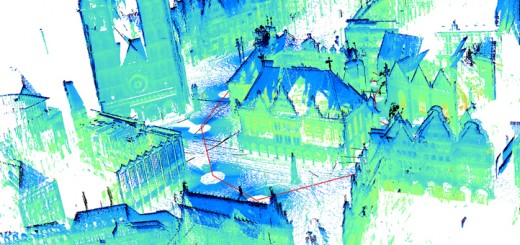

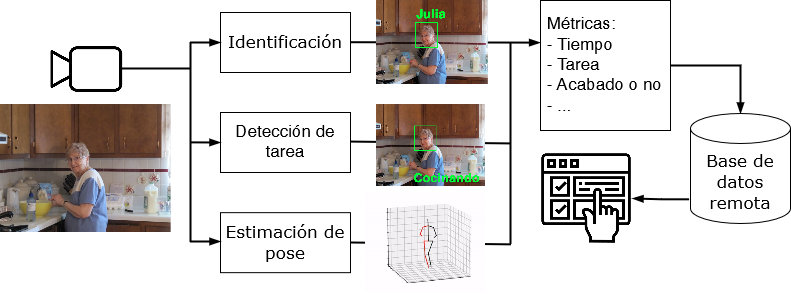

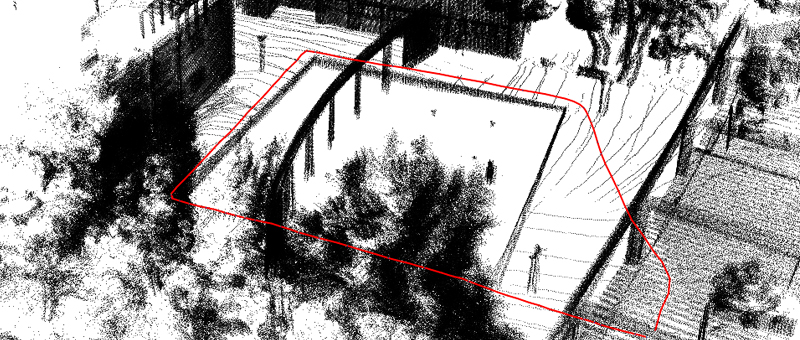

Actualmente existen diversas situaciones donde el uso de un robot podría ser fundamental. Imaginemos una situación de rescate donde queramos obtener un mapa de un edificio en ruinas o bien de un edificio o zona donde se ha producido un secuestro. La introducción de personas puede acarrear un riesgo para sus vidas. La introducción de un sistema robótico autónomo que sea capaz de realizar un mapa preciso del entorno puede servir para minimizar el riesgo. También puede ser interesante introducir robots para vigilancia activa, donde el robot realizaría rondas detectando posibles intrusos o cualquier tipo de detección. La investigación en este campo es muy amplia. Desde hace algunos años se vienen realizando distintas propuestas en este sentido. Sin embargo, consideramos que existe un hueco que este proyecto se plantea llenar. Hasta el momento todas las propuestas (que revisaremos en el apartado de estado del arte) se basan en distintos modelos de sensores (láser, sónar, visión 2D, visión 3D) pero en ningún momento se plantea una comparativa de los modelos perceptivos. Nuestro objetivo principal es analizar las distintas tecnologías de sensores usadas, modelizando sus errores y realizando un estudio que refleje en qué situaciones un sensor es el más adecuado. Por lo tanto, un primer objetivo claro es la modelización de distintos sistemas perceptivos. Un ejemplo claro: si un robot dispone de un láser y una cámara estéreo, cuando estemos detectando zonas con poca textura (donde la visión estéreo no devuelve información o ésta es errónea) el láser puede ayudar a solventar el problema. En este caso, deberemos primero detectar que estamos ante una zona de poca textura lo que aumentará el error del sensor estéreo para posteriormente apoyarnos en el láser para intentar obtener datos más precisos. Son dos problemas separados a solucionar: modelización del error y fusión sensorial. La fusión sensorial hace referencia a cómo mezclar datos sensoriales provenientes de sensores heterogéneos. Nuestro segundo objetivo consistirá en, una vez obtenidos los datos sensoriales, obtener un mapa del entorno que nos permita representar dicha información. Al tratar con datos de distinta naturaleza (se mezclarán datos 3D con imágenes, con datos de láser e incluso señales de redes WiFi) su representación no es inmediata. Aquí aplicaremos técnicas de SLAM (Simultaneos Location And Mapping) que están siendo ampliamente estudiadas en el campo de la robótica. Dentro del campo de estudio del SLAM, existen técnicas que se apoyan en EKF (Extended Kalman Filter). Un punto crítico de esta técnica y que no ha sido resuelto al 100% es la asociación de datos: la identificación de una misma característica en dos instantes de tiempo distintos. Nuestra propuesta es que, al usar una mayor y diferente cantidad de información sensorial, sería posible el encontrar una solución a este problema. Un último objetivo es hacer uso de distintas técnicas de coordinación de robots para llegar a la creación coordinada del mapa. En entornos extensos se hará necesario el uso de grupos de robots para realizar el mapa del entorno. Nuestro planeamiento va más allá que el desarrollado por trabajos previos. En la mayoría de estos trabajos cada robot dispone los mismos tipos de sensores. Si nuestros robots son heterogéneos (puede que distintos robots dispongan de distintos tipos de sensores), debemos introducir una nueva variable, que es el tipo de sensor de que dispone un robot. Un ejemplo claro: volviendo al problema de la falta de textura, si un robot dispone de una cámara estéreo y detecta una estancia con falta de textura, deberá notificarlo al sistema para otro robot con otros sensores exploren esta zona. Nuestro planteamiento es el uso de métodos de coordinación ya existentes e introducir esta nueva variable. Para ello, contactaremos con grupos de nuestro entorno que ya investigan en estas técnicas, tanto de nuestra Universidad como externos. Pensamos que este objetivo permite plantear una futura colaboración y la realización de un proyecto coordinado entre grupos.

Objetivos

Combinación de información sensorial: Identificar y cuantificar el error y el ruido asociado con distintos tipos de sensores. Desarrollar métodos que permitan definir estrategias de selección de información en cada momento. Fusionar información sensorial heterogénea.

Mapeado usando modelos realistas: Desarrollar modelos realistas a partir de la información sensorial que permitan un posterior uso para tareas robóticas (localización, evitación de obstáculos, etc.). Solucionar el problema de la asociación de datos mediante el uso de información proveniente de distintos sensores.

Coordinación de agentes. Estudiar, implementar y seleccionar las técnicas de coordinación de agentes que mejor se adapten a nuestro problema. Desarrollar técnicas de coordinación con agentes heterogéneos.

Personal

- Miguel Cazorla (Investigador principal)

- Juan Manuel Sáez

- Otto Colomina

- Pablo Suau

- Antonio Botía

- José Manuel Pérez

Resultados del proyecto

Tesis defendidas

- Diego Viejo Hernando: Modelización robusta de entornos semi-estructurados: una aplicación al mapeado 6DoF en robótica móvil. Supervisor: Miguel Cazorla. Date: june 2008.

Congresos

- B. Bonev, M. Cazorla, and F. Escolano Ruiz, «Robot navigation behaviors based on omnidirectional vision and information theory,» Journal of physical agents, vol. 1, iss. 1, 2007.

[Bibtex]@article{bonev2007robot, author = {Bonev, Boyan and Cazorla, Miguel and Escolano Ruiz, Francisco }, journal = {Journal of Physical Agents}, publisher = {Red de Agentes Fisicos}, title = {{Robot navigation behaviors based on omnidirectional vision and information theory}}, volume=1, number=1, year = {2007} } - D. Viejo and M. Cazorla, «Plane extraction and error modeling of 3d data,» in International symposium on robotics and automation, 2006.

[Bibtex]@inproceedings{viejo2006plane, author = {Viejo, Diego and Cazorla, Miguel}, booktitle = {International symposium on Robotics and Automation}, title = {{Plane extraction and error modeling of 3d data}}, year = {2006} }

Revistas

-

![[DOI]](https://www.rovit.ua.es/wp-content/plugins/papercite/img/external.png) B. Bonev, F. Escolano, and M. Cazorla, «Feature selection, mutual information, and the classification of high-dimensional patterns,» Pattern analysis and applications, vol. 11, iss. 3-4, p. 309–319, 2008.

B. Bonev, F. Escolano, and M. Cazorla, «Feature selection, mutual information, and the classification of high-dimensional patterns,» Pattern analysis and applications, vol. 11, iss. 3-4, p. 309–319, 2008.

[Bibtex]@article{Bonev:2008aa, abstract = {We propose a novel feature selection filter for supervised learning, which relies on the efficient estimation of the mutual information between a high-dimensional set of features and the classes. We bypass the estimation of the probability density function with the aid of the entropic-graphs approximation of R{\{}e{\}}nyi entropy, and the subsequent approximation of the shannon entropy. Thus, the complexity does not depend on the number of dimensions but on the number of patterns/samples, and the curse of dimensionality is circumvented. We show that it is then possible to outperform algorithms which individually rank features, as well as a greedy algorithm based on the maximal relevance and minimal redundancy criterion. We successfully test our method both in the contexts of image classification and microarray data classification. For most of the tested data sets, we obtain better classification results than those reported in the literature.}, author = {Bonev, Boyan and Escolano, Francisco and Cazorla, Miguel}, doi = {10.1007/s10044-008-0107-0}, issn = {1433-7541}, journal = {Pattern Analysis and Applications}, keywords = {Filter feature selection; Mutual information; Entropy}, number = {3-4}, pages = {309--319}, publisher = {springer-Verlag}, title = {{Feature selection, mutual information, and the classification of high-dimensional patterns}}, url = {http://dx.doi.org/10.1007/s10044-008-0107-0}, volume = {11}, year = {2008} } - D. Viejo and M. Cazorla, «Pose Registration Model Improvement: Crease Detection.» 2007.

[Bibtex]@inproceedings{viejo2007pose, abstract = {several works deal with 3D data in sLAM pro- blem. Data come from a 3D laser sweeping unit or a stereo camera, both providing a huge amount of data. In this paper, we detail an efficient method to find out creases from 3D raw data. This information can be used together with planar patches extracted from 3D raw data in order to build a complete 3D model of the scene. some promising results are shown for both outdoor and indoor environments.}, author = {Viejo, Diego and Cazorla, Miguel}, title = {{Pose Registration Model Improvement: Crease Detection}}, year = {2007} }